Generative AI-Driven Application Development with Java 4章

4. Bring Your Own Model: Self-Hosting with Ollama

Ollama によるセルフホスティング

書籍より

アプリケーションをテストするために使用できる、ローカルにホストされた大規模言語モデル(LLM)/小規模言語モデル(SLM)をセットアップする手順について解説します。

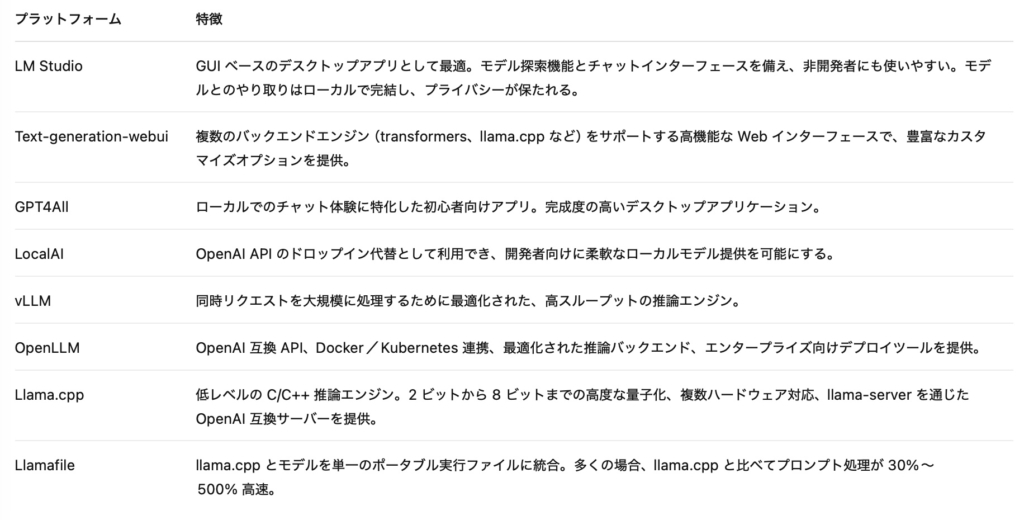

特定のベンダーに縛られることなく、また依存することなく、生成 AI(Gen AI)のホスティングを民主化するために、Ollama のようなアプリケーションが役立ちます。

Ollama とは何か、そして LLM をセルフホスティングするとはどういうことかを学びます。LLM をセルフホスティングとして自分自身のハードウェア上でローカルに実行することで、モデルに対する制御性の向上、プライバシーの強化、そしてクラウドサービスへの依存度の低減といった利点が得られます。

紹介されている手順

- Ollama のインストール

- ローカルホストされた LLM の実行

- Ollama が公開する API を探索する

- 既存アプリケーションへの Ollama の統合